Человек воспитывает машину, как ребенка

У Мелиссы Цефкин интересная работа. Будучи научным руководителем исследовательского центра компании Nissan в Кремниевой долине, она работает вместе с простыми разработчиками автомобилей над созданием следующего поколения беспилотных транспортных средств. Задача Мелиссы — обеспечить беспроблемное взаимодействие человека и машины (другими словами, между водителем и автомобилем), в этом ей помогает образование антрополога.

У Мелиссы Цефкин интересная работа. Будучи научным руководителем исследовательского центра компании Nissan в Кремниевой долине, она работает вместе с простыми разработчиками автомобилей над созданием следующего поколения беспилотных транспортных средств. Задача Мелиссы — обеспечить беспроблемное взаимодействие человека и машины (другими словами, между водителем и автомобилем), в этом ей помогает образование антрополога.

«Необходимо понять людей, если вы хотите предоставить им автоматизированного партнера», — утверждает Мелисса.

Роль Цефкин в компании Nissan — обращать внимание и анализировать те вещи, о которых большинство разработчиков автомобилей и не задумываются. Возьмем, к примеру, правила дорожного движения и дорожные знаки, большинство из которых интуитивно понятны (как в случае запрета на пересечение двойной сплошной линии), однако при определенных условиях люди часто нарушают эти правила (пересекая двойную сплошную, чтобы избежать столкновения). Следует ли программировать самоуправляемые автомобили на нарушение правил в определенной ситуации? Вместе с разработчиками, инженерами-электротехниками и специалистами по искусственному интеллекту Цефкин надеется наделить алгоритмы искусственного интеллекта в беспилотных автомобилях человеческими качествами, такими как готовность нарушить правила в благих целях.

Будучи антропологом в области проектирования транспортных средств, Цефкин относится к группе профессионалов, которых до недавнего времени не существовало. За последние годы системы искусственного интеллекта стали неотъемлемой частью повседневной деятельности компаний, предлагая продукты покупателям, помогая промышленным предприятиям становиться эффективнее, а также обнаруживая и решая проблемы посредством информационных систем. Такая трансформация инициировала широкую дискуссию о возможном исчезновении ряда профессий в будущем. (Подумайте хотя бы о множестве сотрудников складов, которые работают сейчас в компании Amazon.)

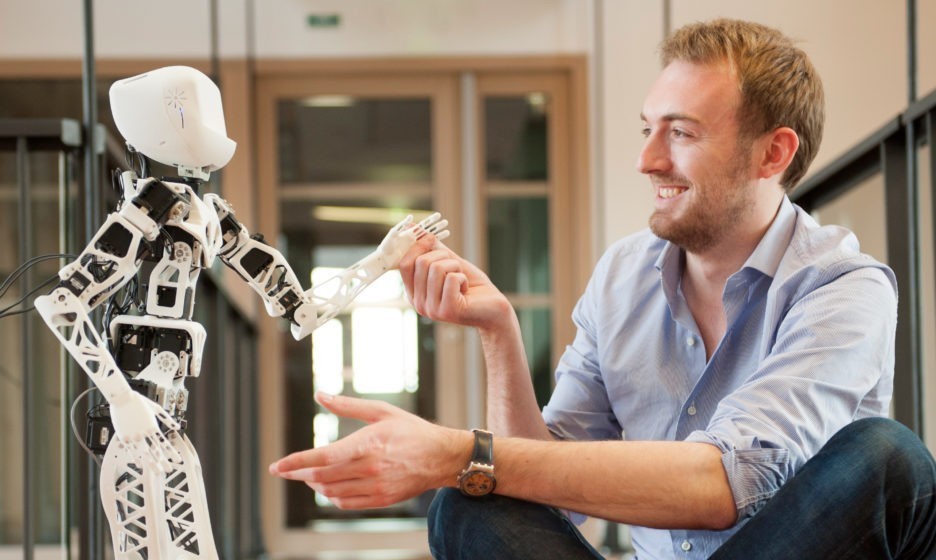

Однако в дискуссиях такого рода часто упускают из виду, что в то же время появится много новых профессий, подобных тому, чем занимается Цефкин. Большинство их будут сфокусированы на обучении машин человеком, причем этот процесс все больше будет напоминать процесс воспитания ребенка. Так системы искусственного интеллекта научатся поддерживать сложное взаимодействие с людьми.

В рамках глобального исследования более полутора тысяч компаний, уже использующих или тестирующих системы искусственного интеллекта и машинного обучения, мы обнаружили ряд новых профессий, роль которых будет только расти. <…>

В прошлом людям приходилось приспосабливаться к работе компьютеров. В настоящее время происходит обратный процесс — системы искусственного интеллекта учатся тому, как адаптироваться к нам.

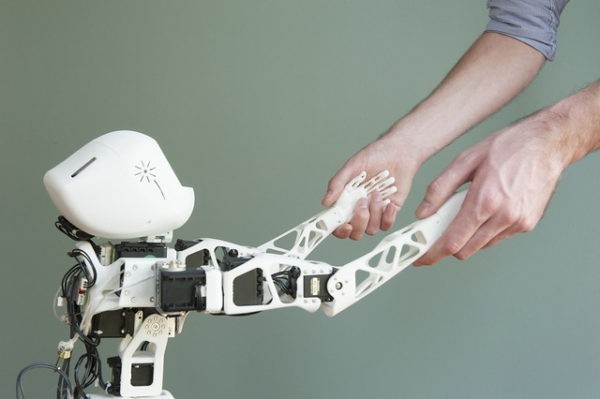

Для достижения этой цели им требуется всестороннее обучение. Без [новых специалистов] системы искусственного интеллекта невозможно будет обучить тому, как выполнять определенные задачи или как действовать немного более… очеловеченно. <…>

Физические роботы — не единственный тип систем искусственного интеллекта, которым необходимо обучение. Интеллектуальное программное обеспечение также нуждается в обучении — и в этом случае очень важно, чтобы обучающиеся машины обрели человекоподобные черты. В самых простых случаях специалисты по обучению помогают системам распознавания естественного языка и «переводчикам» делать меньше ошибок. В более сложных случаях алгоритмы искусственного интеллекта необходимо научить имитировать человеческое поведение. Например, чат-боты, обслуживающие клиентов, должны научиться распознавать неочевидные моменты человеческого общения.

В Yahoo! специалисты по обучению искусственного интеллекта стремятся научить корпоративную систему обработки естественного языка тому, что люди не всегда имеют в виду то, что говорят. К настоящему времени компания разработала алгоритм, способный обнаруживать сарказм в социальных сетях и на веб-сайтах с точностью до 80%. <…>

Сочувствие, сострадание и даже юмор

Специалист по обучению эмпатии — это человек, который учит системы искусственного интеллекта демонстрировать сочувствие. Такая задача может показаться надуманной, однако стартап Koko, созданный в медиалаборатории Массачусетского технологического института, разработал систему машинного обучения, которая призвана помочь таким чат-ботам, как Siri компании Apple и Alexa компании Amazon, реагировать на вопросы пользователей с сочувствием и глубоким пониманием.

В настоящее время специалисты обучают алгоритм Koko более чутко реагировать на запросы людей, которые, например, опечалены потерей багажа, покупкой некачественного товара или мигающим монитором, который никак не удается починить. Цель — добиться того, чтобы система обсуждала с человеком проблему или сложную ситуацию, проявляя сочувствие, сострадание, а может, даже юмор. Каждый раз, когда алгоритм Koko реагирует ненадлежащим образом, специалист по обучению помогает ему внести необходимые коррективы в свои действия. Со временем такой алгоритм машинного обучения обретет способность давать лучший ответ. <…>

Без алгоритма Koko Alexa реагирует на опасения пользователя заранее заготовленными, повторяющимися фразами, такими как «Мне жаль это слышать» или «Порой помогает разговор с другом». Благодаря алгоритму Koko бот Alexa способен оказать гораздо более существенную поддержку. Вот как звучит ответ виртуального помощника Alexa с алгоритмом Koko человеку, который волнуется перед предстоящим экзаменом:

«Экзамены действительно вызывают стресс, однако небольшое беспокойство помогает добиться успеха. Оно обостряет интеллект… Так организм готовится действовать. На самом деле это даже полезно. Нервозность можно воспринимать как секретное оружие. Я знаю: это легче сказать, чем сделать. Но я думаю, ты сдашь экзамен гораздо лучше, чем тебе кажется».

Помимо обучения эмпатии усовершенствованные системы искусственного интеллекта будут также учиться тому, как стать более похожими на человека, — им помогут в этом специалисты по обучению личностным качествам. <…> Возьмем, к примеру, уверенный, компетентный и заботливый стиль общения системы Cortana. Благодаря интенсивному обучению специалистами Microsoft Cortana производит впечатление собеседника, который всегда готов помочь, но при этом не склонен к менторскому тону. Например, Cortana начнет понимать, в каких случаях конкретный человек наиболее восприимчив к рекомендациям. <…>

У специалистов по обучению личностным качествам может быть разное образование и опыт работы. Так, Робин Юинг в прошлом писала сценарии и продавала их голливудским киностудиям. В настоящее время она применяет свои творческие способности, помогая инженерам развивать личностные качества Sophie — программы искусственного интеллекта в области здравоохранения. Среди многих других задач Sophie напоминает пользователям о том, чтобы они приняли лекарства, и регулярно связывается с ними, чтобы проверить их самочувствие.

Безусловно, у таких специалистов, как Юинг, нет резюме, типичного для сферы высоких технологий.

В компании Microsoft развитием личностных качеств виртуального помощника Cortana занимается команда, в состав которой входят поэт, писатель и драматург. <…>

Страх перед мрачным будущим

В 2015 году на заводе компании Volkswagen в Германии робот нанес сотруднику смертельные увечья. Трагическая гибель рабочего привлекла внимание общества к растущей зависимости от автоматизированных инструментов. С тех пор как компьютеры начали брать на себя выполнение все более сложных задач, усиливаются опасения, что машины могут выйти из-под контроля. От компьютера HAL из фильма «2001 год: Космическая одиссея» до киборгов из франшизы «Терминатор» — популярная культура только подогревает тревоги людей. Однако робот в Германии не совершал умышленного нападения на рабочего. Согласно первым отчетам, причина трагедии заключалась в программной ошибке — другими словами, в ошибке человека.

Это ужасающее происшествие — исключительный случай, однако обеспечение корректного использования искусственного интеллекта — первоочередная обязанность представителей новой профессии: экспертов по устойчивости, которые должны постоянно работать над тем, чтобы системы искусственного интеллекта функционировали надлежащим образом как инструменты, призванные обслуживать людей, помогать им выполнять свою работу и облегчать их жизнь. Таким образом эксперты по устойчивости систем искусственного интеллекта помогут развеять страхи перед мрачным будущим, в котором роботы станут разумными и превзойдут человеческое общество.

Очевидно, один из лучших способов добиться того, чтобы сложные роботы и другие системы искусственного интеллекта функционировали так, как было задумано, — изначально правильно проектировать их. Именно в этом случае компаниям понадобятся специалисты по контекстному дизайну. Разрабатывая новую систему, они должны учитывать самые разные факторы, зависящие от контекста, такие как бизнес-среда, задача бизнес-процесса, пользователи, культурные коды и т. д. Важную роль могут играть даже, на первый взгляд, мелкие детали.

Когда компании General Motors и Fanuc проектировали нового робота для гибкого автоматизированного производства, призванного работать бок о бок с людьми, возникли трудности с выбором цвета для него. Оранжевый символизировал опасность, а желтый можно было интерпретировать как предупреждение. В конечном счете остановились на цвете лайма, который они назвали «безопасным зеленым».

Три закона робототехники

Безусловно, даже грамотно спроектированные системы могут создавать определенные проблемы, а в некоторых случаях проблема заключается в чересчур хорошем функционировании технологии, что приводит к непреднамеренному нанесению вреда.

Много лет назад известный писатель-фантаст Айзек Азимов сформулировал три закона робототехники:

— Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

— Робот должен повиноваться всем приказам человека, кроме тех случаев, когда эти приказы противоречат первому закону.

— Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит первому или второму законам.

Впервые изложенные в рассказе «Хоровод» (1942), эти три закона актуальны до сих пор, однако это только отправная точка. Например, должен ли беспилотный автомобиль, пытаясь защитить своих пассажиров, свернуть в сторону, чтобы не сбить выбежавшего на дорогу ребенка, если при этом он может совершить наезд на пешехода? Именно из-за таких вопросов компаниям, которые проектируют и используют сложные технологии искусственного интеллекта, понадобятся специалисты по безопасности систем искусственного интеллекта. Они должны делать все от них зависящее, чтобы предвидеть непреднамеренные результаты действий системы искусственного интеллекта, а также без промедления устранять последствия любых происшествий.

По итогам недавнего исследования Accenture мы обнаружили, что менее трети компаний демонстрируют высокий уровень доверия к справедливости и контролируемости систем искусственного интеллекта, а также что менее половины компаний испытывают столь же высокое доверие к безопасности этих систем. Исследования показали, что каждый третий опасается искусственного интеллекта, а каждый четвертый убежден, что эта технология нанесет вред обществу. Безусловно, это указывает на фундаментальные проблемы, которые необходимо решить, чтобы и впредь использовать технологии искусственного интеллекта.